🧠 ReAct: Sinergia entre Raciocínio e Atuação em Modelos de Linguagem

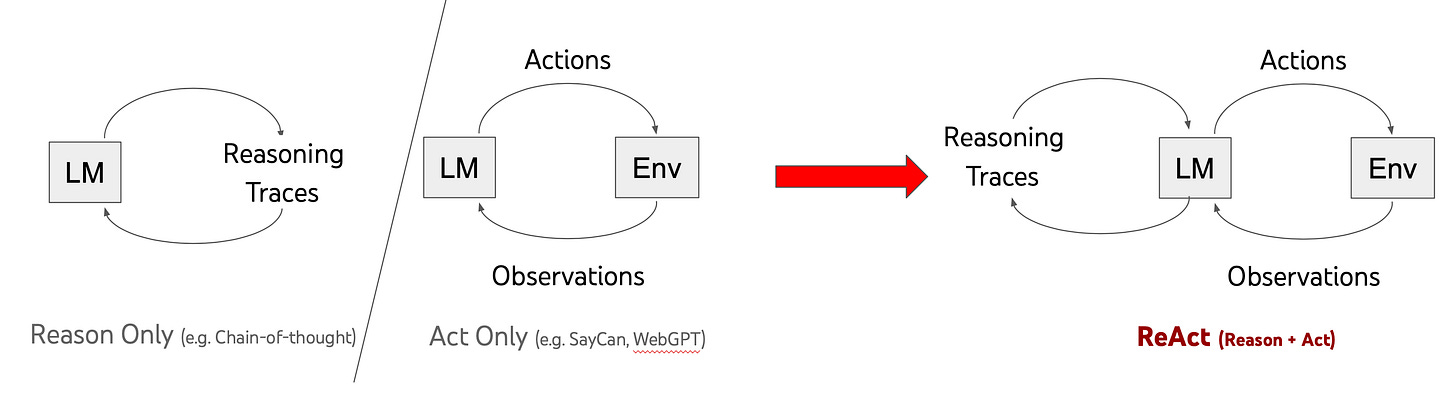

Os modelos de linguagem evoluíram rapidamente em duas frentes: raciocínio lógico (com chain-of-thought prompting) e capacidade de agir (como WebGPT, SayCan). Mas, até agora, esses progressos seguiram caminhos separados. ReAct propõe: por que não unir essas duas forças?

Abstrato

ReAct é uma abordagem inovadora que intercala dois elementos fundamentais nos LLMs:

Traços de raciocínio (“Thought…)**: ajudam o modelo a planejar, ajustar e tratar exceções.

Ações (“Action…)**: permitem interagir com o ambiente ou APIs — como Wikipedia — e incorporar esse feedback ao raciocínio (arxiv.org, react-lm.github.io).

Benefícios observados:

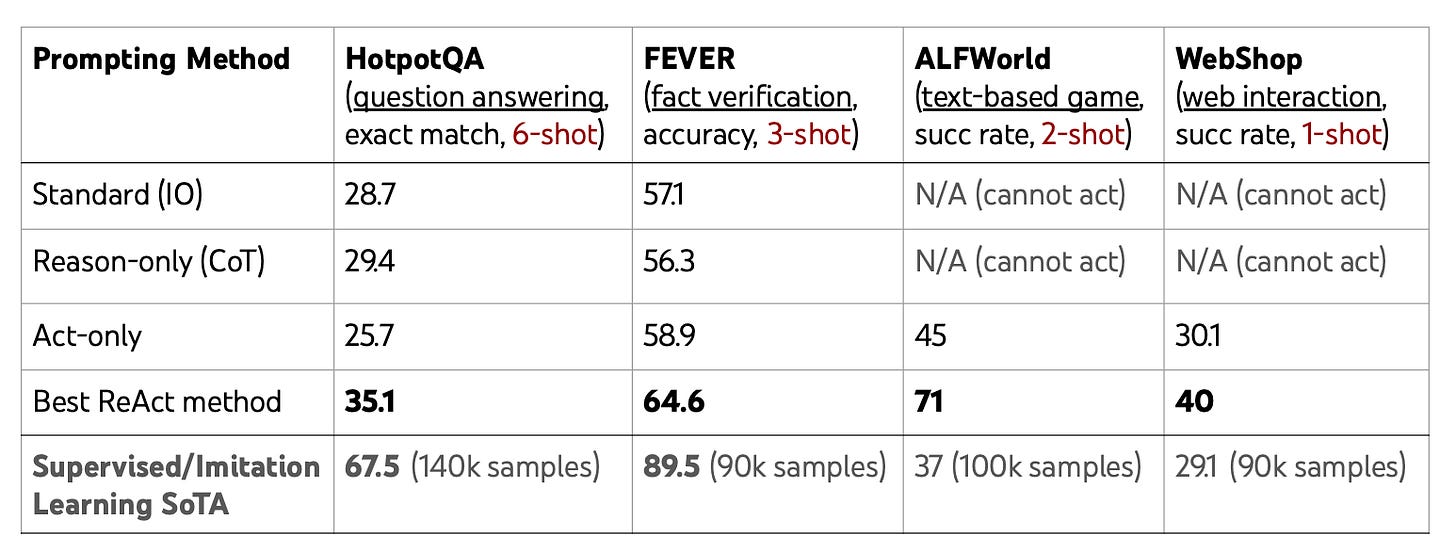

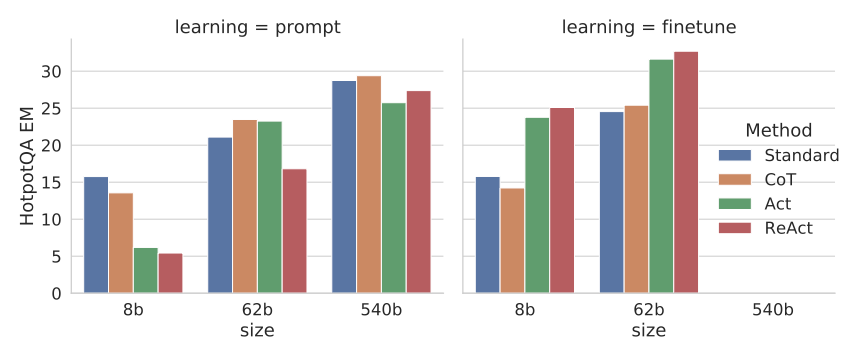

Tarefa Métrica Resultado Com ReAct HotpotQA¹ Exact Match +2–6% vs CoT FEVER² Acurácia +4–8% vs CoT ALFWorld Taxa de sucesso +34 pontos WebShop Taxa de sucesso +10 pontos

¹Q&A com múltiplas etapas

²Verificação de fatos (research.google, medium.com)

Como funciona o prompting ReAct

A estrutura básica de um prompt ReAct alterna “Thought → Action → Observation” diversas vezes. Veja um exemplo simplificado de HotpotQA: (promptingguide.ai)

Question: Quem hospeda o show “Mystère” do Cirque du Soleil?

Thought: Preciso descobrir o hotel, depois o número de quartos.

Action: Search["Cirque du Soleil Mystère show"]

Observation: "Mystère" é no Treasure Island Hotel & Casino em Las Vegas.

Thought: Agora buscar o número de quartos.

Action: Search["Treasure Island Hotel and Casino number of rooms"]

Observation: [resultado do search]

Thought: Resumo final da resposta…

Action: Finish["…"]

🔍 Esse loop permite que o modelo planeje, aja, veja, e replique com base no que aprendeu.

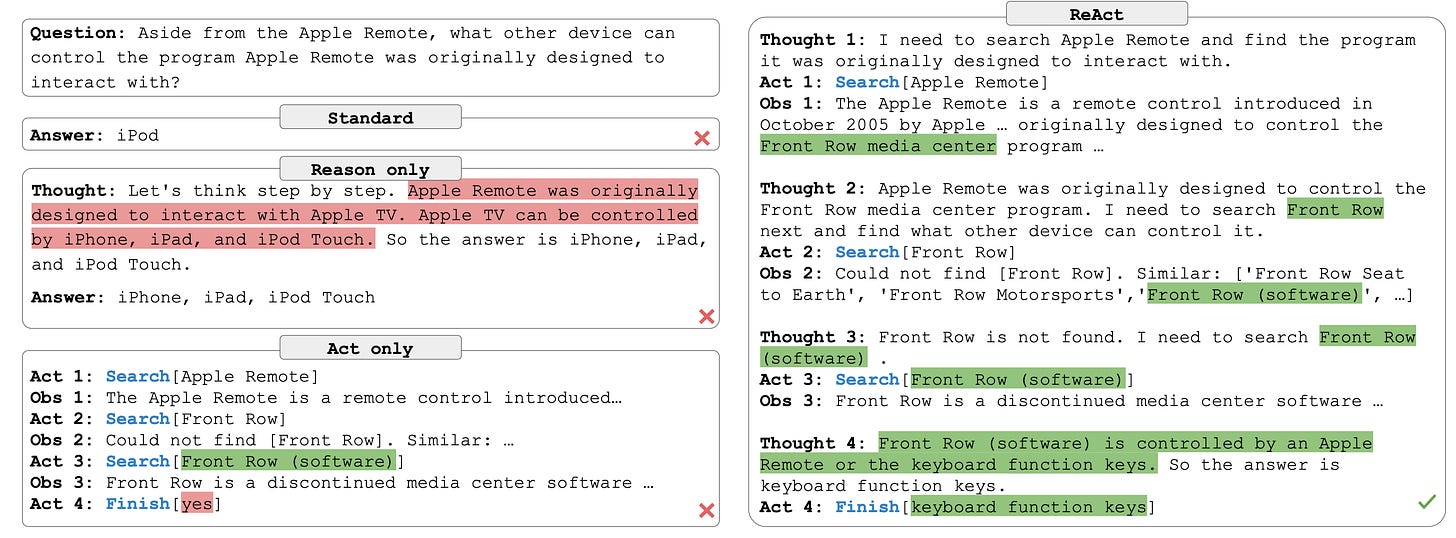

O que acontece sem ReAct?

Com CoT clássico: o modelo raciocina, mas pode alucinar fatos sem verificar fontes externas.

Com “Act‑only”: consegue buscar, mas falha em sintetizar o resultado de forma estruturada (research.google).

Exemplos reais

🔍 Tarefa: verificação de afirmação

CoT: “X é factual porque….” → erro.

Act‑only: busca, mas não entende o contexto → resposta vaga.

ReAct: raciocina, busca, raciocina de novo → resposta correta e fundamentada (research.google).

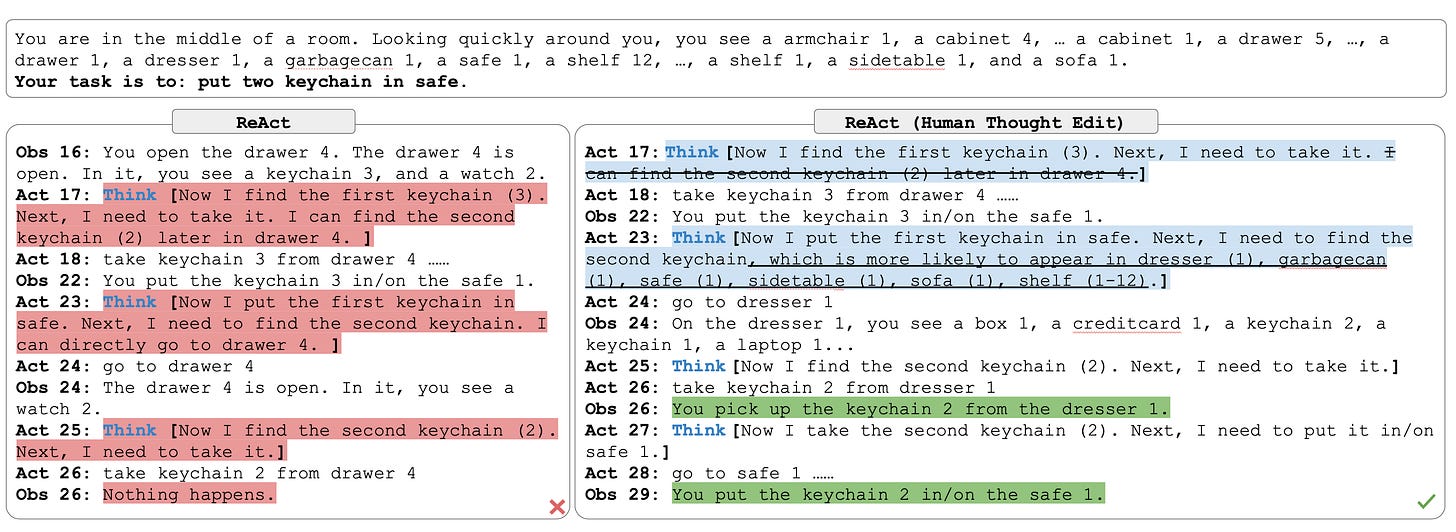

🕹️ Jogo ALFWorld

Script ReAct: pensamento esparso, ações assertivas.

Permite inspeção e ajuste humano — se o agente erra, basta editar um “Thought” e realinhar o comportamento (arxiv.org, research.google).

ReAct + fine‑tuning

Ajuste fino com dados ReAct melhora modelos menores, superando modelos grandes apenas com prompting.

É o formato mais eficiente de fine‑tuning para tarefas como HotpotQA (react-lm.github.io, arxiv.org).

Porque isso importa?

Maior confiança e interpretabilidade: traços justificam ações do agente, facilitando auditoria.

Menos alucinação e erros de trace logística: o loop de verificação corrige inconsistências.

Versatilidade: único framework para Q&A, verificação de fatos, navegação, compras online, games de texto...

Acelerador para agentes autônomos: ReAct pode servir como base para bots mais robustos com integração de APIs e processamento simbólico.

🔧 Orientações Práticas para Engenheiros

Monte few‑shots ReAct com traços humanos bem elaborados.

Intercale

Thought → Action → Observationquantas vezes necessário.Incorpore ferramentas externas (APIs, motores de busca, bases de dados).

Apresente caminhos de raciocínio breves, dando ao modelo margens para escolher quando pensar ou agir.

Utilize human‑in‑the‑loop para interceptar e ajustar raciocínios falhos.

Aplique fine‑tuning quando dados perforam o limite do contexto ou rendimento do prompting.

🧭 Caminhos Futuros

Escalar para agentes que executam ações no mundo real, com físicos e robôs.

Combinar ReAct com RLHF, Fidelidade Simbólica e Lógica Formal.

Ampliar a base de ações: chamadas de função, APIs dinâmicas, sensores...

✅ Conclusão

ReAct representa um salto na arquitetura de agentes LLM, combinando pensamento estruturado com ação informada. Com ganhos significativos em precisão, confiança e interpretação, ele redefine o design de agentes autônomos.

Em suma: ReAct faz o seu agente pensar e agir como um humano técnico experiente.

Citações

Yao et al. – ReAct: Synergizing Reasoning and Acting in Language Models (research.google, arxiv.org, react-lm.github.io)

PromptingGuide e Medium – visão geral e exemplos práticos

Estudos em ALFWorld/WebShop – sucessos e correções human‑in‑the‑loop (arxiv.org)